今天,在一些医院里,医护人员的部分工作已经交给5G智能医护机器人。一台长得像“大白”的机器人驻守在门诊大厅,为患者导诊,进行防疫宣传;另一台转动灵活的机器人正背着药箱和消毒水箱,进行医药配送、地面消杀和清洁。

“疫情的发生,让机器人协助人类进行急难险重工作的作用得到集中体现。”事实上,能有这样的效果,得益于近年来机器人的视觉系统发展。

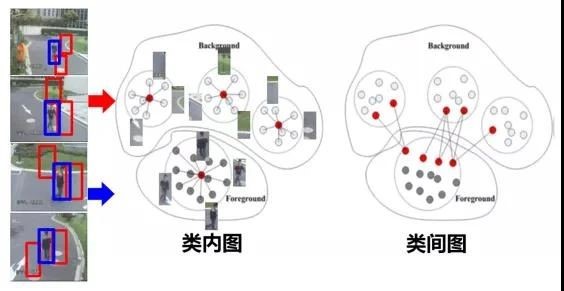

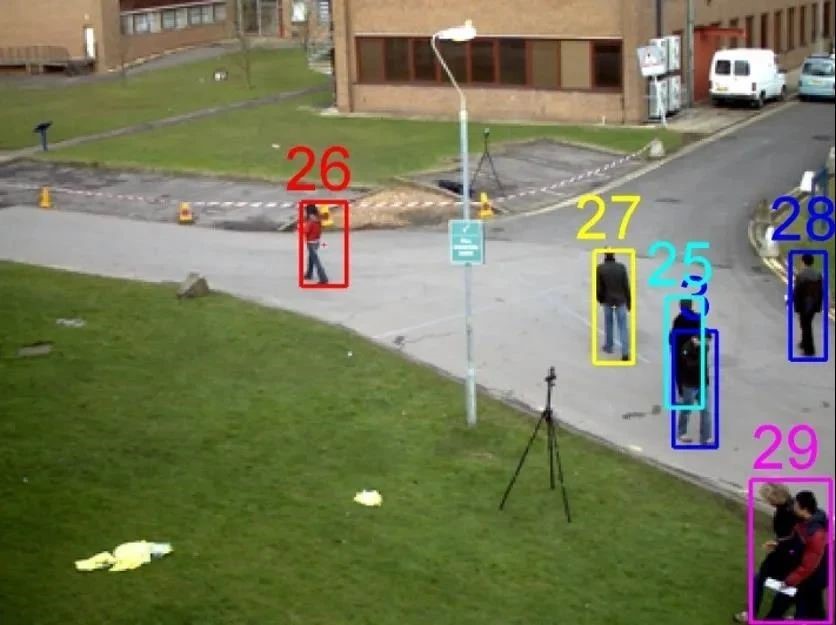

学习式目标观测跟踪

视觉系统是人工智能的“眼睛”。多年来,浙江工业大学计算机科学与技术学院陈胜勇教授团队一直致力于场景目标运动状态的视觉分析方法研究,他主持的“视觉系统中的目标物运动状态分析”项目荣获2019年度浙江省自然科学一等奖。

该项目是以人工智能为基础的计算机分析技术,目的是为了让系统可以随时监测场景和物体的变化情况,是机器实现智能决策和自主行为必备的功能。 同时应用最先进的人工智能和机器视觉技术,帮助计算机和机器人对环境中的运动对象进行运动状态的跟踪和分析。就好比给机器人装上了“眼睛”,使其能够随时监测场景和物体的变化情况。一旦掌握了周边环境变化情况,机器人就能进一步实现智能决策和自主行为。比如,一条固体垃圾资源再生的生产线,如果机器手臂不长“眼睛”,那就需要借助人类的“眼睛”分辨哪些是可利用的建筑垃圾材料,而这一技术恰恰弥补了机器手臂“盲目”的缺点,实现了精准筛选。在交通监控上,这双“眼睛”能够迅速发现异常行驶的汽车轨迹,并及时报警,大大减轻了民警的劳动强度,解放了大量的纠违警力,又能为抢救伤员赢得宝贵的时间。

场景运动状态分析

无人机应用

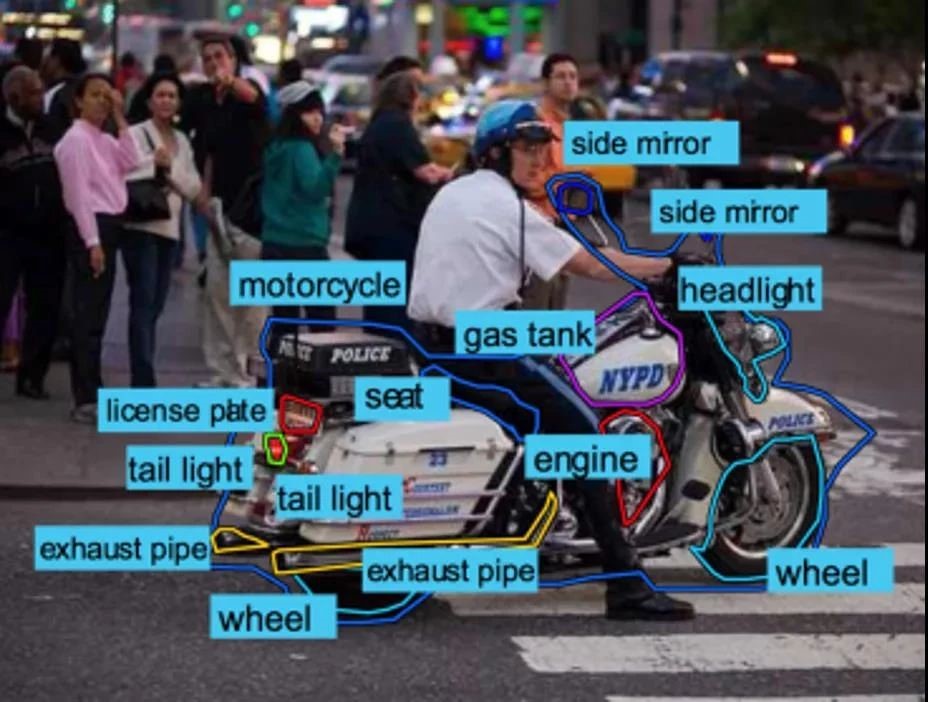

场景内容分析

该项目建立了一套科学理论体系,它突破了在陌生复杂环境中对象分割和场景描述问题。能够快速准确地分割场景中静止和运动的个体目标,还能提供计算机和机器人可以理解的场景内容描述。它突破了复杂环境中多个目标跟踪问题。开创性地应用多种群序列粒子群优化技术,能够准确实时跟踪场景中多个运动目标。它突破了复杂场景中目标对象的运动状态分析问题。提出新的理论,解决了传统技术面临的噪声和遮挡问题。